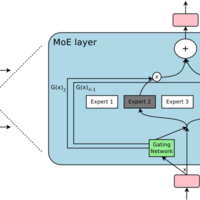

論文解説 Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer (MoE)

本紙は ICLR 2017 のポスターセッションでもっとも注目を集めた論文です.傍若無人なほど巨大な (Outrageously Large) 混合エキスパートと少数のエキスパートを選択するゲーティングネットワークを用意し,ゲーティングで選択した少数のエキスパートのみ順/逆伝播を実行することで巨大なモデルであっても少ない時間で訓練…